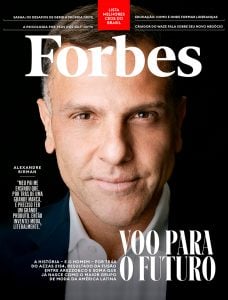

O primeiro indício de Jonathan Ross de que algo estava errado aconteceu em fevereiro, enquanto ele falava com uma série de membros do Parlamento norueguês e executivos de tecnologia em Oslo. Ross, o CEO de 42 anos da startup de chips de Inteligência Artificial (IA) Groq, estava no meio de uma demonstração que ele esperava que revitalizasse a empresa definhada: um chatbot de IA que poderia responder perguntas quase instantaneamente, mais rápido do que um humano pode ler.

Mas, por algum motivo, estava um pouco atrasado. Isso deixou Ross nervoso, que estava lançando um data center europeu com tecnologia Groq que mostraria os chips especializados responsáveis por essas respostas super-rápidas. “Eu simplesmente continuei verificando os números”, ele lembra. “As pessoas não sabiam por que eu estava tão distraído.” O culpado foi um influxo de novos usuários. Um dia antes da reunião de Ross em Oslo, um tuíte viral de um desenvolvedor entusiasmado falando sobre “um mecanismo de resposta de IA extremamente rápido” enviou toneladas de tráfego novo para a demonstração online, sobrecarregando os servidores da empresa.

Era um problema, mas um bom problema para se ter. Quando fundou a Groq há oito anos, a ideia de Ross era projetar chips de IA explicitamente para o que é conhecido na indústria como “inferência”: a parte da inteligência artificial que imita o raciocínio humano aplicando o que aprendeu a novas situações. É o que permite que seu smartphone identifique seu cachorro como um Corgi em uma foto que ele nunca viu antes, ou um gerador de imagens para imaginar o Papa Francisco em um casaco Balenciaga.

É bem diferente da outra porcaria computacional da IA: treinar os modelos massivos para começar. Mas até a OpenAI lançar o ChatGPT no final de 2022, desencadeando um frenesi global de IA, a demanda por inferência super-rápida era limitada, e a empresa estava mancando. “A Groq quase morreu muitas vezes”, diz Ross de dentro do laboratório de semicondutores da startup em San Jose, Califórnia, relembrando um ponto baixo em 2019, quando a startup estava a um mês de ficar sem dinheiro. “Começamos a Groq talvez um pouco mais cedo.”

Mas agora, com a demanda por poder computacional para construir e executar modelos de IA tão intensa que está contribuindo para uma escassez global de eletricidade, a hora da Groq aparentemente chegou — seja como um potencial criador de ruído ou alvo de aquisição para os gigantes de chips. Na segunda-feira (5), a empresa disse exclusivamente à Forbes que levantou US$ 640 milhões (R$ 3,7 bilhões) em uma rodada de investimento, elevando-apara uma avaliação de US$ 2,8 bilhões (R$ 15,96 bilhões), ante US$ 1,1 bilhão (R$ 6,27 bilhões) em 2021.

A rodada, liderada pela BlackRock, também inclui a Cisco Investments e o Samsung Catalyst Fund – um braço de risco da gigante da eletrônica que se concentra em infraestrutura e IA.

Rumo às big techs

A necessidade de poder de computação é tão insaciável que elevou o valor de mercado da Nvidia para US$ 3 trilhões (R$ 17,1 trilhões) em uma receita de US$ 60,9 bilhões (R$ 347,13 bilhões) em 2023. A Groq ainda é pequena em comparação, com vendas em 2023 tão baixas quanto US$ 3,4 milhões (R$ 19,4 milhões) e um prejuízo líquido de US$ 88,3 milhões (R$ 503,3 milhões), de acordo com documentos financeiros vistos pela Forbes.

Mas, à medida que o interesse em seus chips aumenta, a empresa previu talvez US$ 100 milhões (R$ 570 milhões) otimistas em vendas este ano, dizem as fontes, embora duvidassem que a fosse capaz de atingir essa meta. A Groq se recusou a comentar esses números.

Com o mercado de chips de IA previsto para atingir US$ 1,1 trilhão (R$ 6,27 trilhões) até 2027, Ross vê uma oportunidade de abocanhar uma fatia da impressionante fatia de 80% da Nvidia ao focar em inferência. Esse mercado deve valer cerca de US$ 39 bilhões (R$ 222,3 bilhões) este ano, com estimativa de aumentar para US$ 60,7 bilhões (R$ 345,99 bilhões) nos próximos quatro anos, de acordo com a empresa de pesquisa IDC. “A computação é o novo petróleo”, diz Ross.

Desafiantes como a Groq estão otimistas porque os chips da Nvidia nem sequer foram originalmente construídos para IA. Quando o CEO Jensen Huang estreou suas unidades de processamento gráfico (GPUs) em 1999, elas foram projetadas para rodar videogames com uso intensivo de gráficos. Foi uma coincidência que eles tenham sido os chips mais adequados para treinar IA. Mas a Groq e uma nova onda de startups de chips de última geração, incluindo a Cerebras (avaliação em US$ 4 bilhões ou R$ 22,8 bilhões) e a SambaNova (avaliação a US$ 5,1 bilhões ou R$ 29,07 bilhões), veem uma abertura. “Ninguém que começou com uma folha de papel em branco escolheu fazer uma GPU para esse tipo de trabalho”, diz Andrew Feldman, CEO da Cerebras.

Não são apenas startups que buscam destronar a Nvidia. Tanto a Amazon quanto a Microsoft estão construindo seus próprios chips de IA. Mas os chips da Groq, chamados de Unidades de Processamento de Linguagem (LPUs), são tão rápidos que a empresa acha que tem uma chance de lutar. Em um pitch deck para investidores, a empresa os anuncia como quatro vezes mais rápidos, cinco vezes mais baratos e três vezes mais eficientes em termos de energia do que as GPUs da Nvidia quando são usadas para inferência. A Nvidia se recusou a comentar a alegação.

“Suas velocidades de inferência são claramente melhores do que qualquer outra coisa no mercado”, diz Aemish Shah, cofundador da General Global Capital, que investiu em várias rodadas de financiamento da Groq.

A Groq começou a vender seus chips há dois anos e, desde então, ganhou clientes como o Argonne National Labs, uma instalação federal de pesquisa com origens no Projeto Manhattan, que usou chips Groq para estudar a fusão nuclear, o tipo de energia que alimenta o sol. A Aramco Digital, o braço de tecnologia da empresa petrolífera saudita, também fechou uma parceria para usar chips Groq.

Em março, a Groq lançou o GroqCloud, onde os desenvolvedores podem alugar acesso aos seus chips sem comprá-los diretamente. Para atrair desenvolvedores, a Groq ofereceu acesso gratuito: no primeiro mês, 70.000 se inscreveram. Agora, são 350.000 e contando. Em 30 de junho, a empresa ativou os pagamentos e acabou de contratar Stuart Pann, um ex-executivo da Intel e agora COO da Groq, para aumentar rapidamente a receita e as operações. Pann está otimista sobre o crescimento: mais de um quarto dos tickets de clientes da GroqCloud são solicitações para pagar por mais poder de computação.

“O chip Groq realmente vai direto na jugular”, diz o cientista chefe da Meta, Yann LeCun, ex-professor de ciência da computação de Ross na NYU, que recentemente se juntou à Groq como consultor técnico. No final do mês passado, o CEO Mark Zuckerberg anunciou que a Groq seria uma das empresas que forneceria chips para executar inferência para o novo modelo Llama 3.1 da Meta, chamando a startup de “inovadores”.

Ross começou sua carreira no Google, onde trabalhou na equipe que criou os semicondutores “tensor processing units” da empresa, que são otimizados para aprendizado de máquina. Ele saiu em 2016 para começar a Groq, junto com o colega engenheiro do Google Doug Wightman, que foi o primeiro CEO da empresa. Naquele ano, a Groq levantou uma rodada de US$ 10 milhões (R$ 57 milhões) liderada pelo fundo de capital de risco Social Capital. Mas a partir daí, encontrar novos investidores foi difícil. O cofundador da Groq, Wightman, saiu alguns anos depois e não respondeu aos pedidos de entrevista.

Ainda há muitos pessimistas. Um capitalista de risco que recusou a rodada da Série D da empresa caracterizou a abordagem da Groq como “nova”, mas não achou que sua propriedade intelectual fosse defensável a longo prazo. Mitesh Agrawal, chefe de nuvem da startup de infraestrutura de IA de US$ 1,5 bilhão (R$ 8,55 bilhões) Lambda Labs, diz que sua empresa não tem planos de oferecer Groq ou quaisquer outros chips especializados em sua nuvem. “É muito difícil agora pensar além da Nvidia”, diz ele. Outros questionam a eficiência de custo dos chips da Groq em escala.

Ross sabe que é uma subida íngreme. “É como se fôssemos o Novato do Ano”, ele diz. “Ainda não estamos nem perto da Nvidia. Então todos os olhos estão em nós. E é tipo, o que você vai fazer a seguir?”