Na semana passada, a Midjourney, plataforma de geração de imagens feitas por inteligência artificial (IA), suspendeu as experimentações sem custo para os usuários. A medida ocorreu após a proliferação de imagens falsas criadas na plataforma de personalidades como Papa Francisco e Donald Trump. Segundo o CEO David Holz, a “demanda extraordinária pelo serviço requer ajustes.”

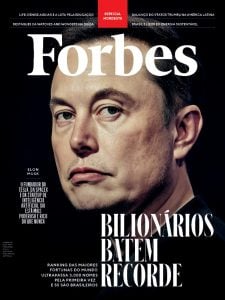

Há alguns dias, uma carta assinada por quase 3 mil pessoas, entre cientistas, empresários, pensadores e Elon Musk, pedia a pausa nos testes com IA alegando que era necessária uma reflexão sobre a evolução e as aplicações da tecnologia. No centro das discussões, a OpenAI, dona do ChatGPT, serviço conversacional focado em textos, já vinha se defendendo alegando que a regulação é necessária. “Quando estamos desenvolvendo essas tecnologias, buscamos inteligência geral com alta confiabilidade – e isso deve ser feito com segurança”, afirmou Mira Murati, diretora de tecnologia da empresa. O ChatGPT mantém uma versão gratuita, mas já testa a assinatura premium.

Leia mais: O que a imagem fake do Papa diz sobre o futuro da IA?

“O fato de esses serviços não cobrarem no início tem uma razão: a evolução da própria plataforma, já que para aprimorar a IA você precisa de um alto volume de informações e pessoas utilizando é a grande validação. Naturalmente, como qualquer nova tecnologia, não sabemos como ela será utilizada ou até que ponto ela pode ser usada para o bem ou para mal, ainda mais neste momento de sociedade onde as pessoas compartilham qualquer coisa sem preocupação de origem ou veracidade”, explica Breno Masi, empreendedor, investidor e fundador da Afterverse.

Para Masi, as fake news ganham mais repertório com as ferramentas de IA. “Nos casos recentes envolvendo imagens do Papa ou Trump, ficou claro o nível de precisão e realismo das imagens. Não acho que cobrar pelo serviço resolva já que grande parte das fake news geradas surgem de interesses e demandam estruturas, ou seja, vão utilizar de qualquer forma. A solução que vejo aqui é, primeiro, um login que ajude na identificação e responsabilização e uma marca que identifique o que foi criado por IA.”

“Nos casos recentes envolvendo o Papa ou Trump, ficou claro o nível de precisão e realismo das imagens. Não acho que cobrar pelo serviço resolva já que grande parte das fake news geradas tem interesses e estruturas por trás, ou seja, vão utilizar de qualquer forma”,

Breno Masi

Marcelo Pádua, Sócio da Cascione Advogados e especialista em Tecnologia e Inovação, explica que, ainda que não esteja clara a motivação do Midjourney ao cobrar pelo serviço, pode existir uma forma de reduzir o mau uso da ferramenta. “Lembramos que essa medida, por si só, não assegura que conteúdos infringentes não serão mais produzidos mediante o uso de soluções de IA da empresa. Dessa forma e considerando um contexto em que o desenvolvimento e uso de IA ainda não são regulamentados em diversos países (como no Brasil), é recomendável que empresas fornecedoras de soluções de IA adotem procedimentos de governança interna com o intuito de restringir o uso indevido, permitir a rastreabilidade dos conteúdos produzidos a partir dos ‘inputs’ dos usuários – para a posterior responsabilização destes, e assegurar às pessoas impactadas pelos conteúdos determinados direitos, destacando-se os direitos de informação, contestação e revisão.”

Também na semana passada, o regulador que garante a proteção de dados da Itália, alegou que ChatGPT aparenta ser um grande risco para a privacidade dos usuários, podendo até mesmo divulgar informações pessoais em relação a pagamentos na internet. O GDPR, que representa a principal Lei de Dados e Privacidade da Europa, define a maneira como usar, processar e armazenar os dados pessoais e afirma que, além de bloquear o chatbot, irá investigar se o software cumpre a Lei.

“Embora o CEO David Holz tenha dito que a decisão de suspensão dos testes gratuitos do Midjourney foi motivada pelo excesso de fluxo de novos usuários, a repercussão das imagens falsas que viralizaram certamente teve um papel importante na decisão. A empresa pode estar preocupada com possíveis repercussões negativas para sua confiança e com a possibilidade de enfrentar pressão regulatória ou jurídica. Inclusive, tal providência pode ser vista como um exemplo de autorregulação, onde a empresa reconhece a necessidade de agir com responsabilidade e toma medidas preventivas para evitar problemas futuros, em vez de esperar que a legislação ou regulamento imponham limites às suas atividades”, pontua Antonielle.

Leia mais: Muito além do Papa: veja imagens de outros famosos criados por IA

“Isso mostra que, apesar de a tecnologia ser neutra, as empresas que a desenvolvem têm uma responsabilidade ética e social em relação ao uso que é feito de suas ferramentas. No entanto, a autorregulação não é suficiente por si só. É importante que o governo e a sociedade também estejam engajados no combate à desinformação e às fake news, criando regulamentações e estratégias eficazes para combater esse problema”, explica Antonielle Freitas, DPO (Data Protection Officer) do escritório Viseu Advogados e Membro da Comissão Especial de Privacidade e Proteção de Dados da OAB/SP.

Direitos autorais e Propriedade Intelectual

Ferramenta importante para a potencialização e desenvolvimento de propriedades intelectuais (IPs), as plataformas de IA podem ser ferramentas importantes, e essa é uma outra discussão colocada no contexto do desenvolvimento da tecnologia. Há que se considerar, porém, todos os riscos envolvidos, sobretudo com direitos autorais, como explica Bruno D’Angelo, fundador da WIP, startup especializada em desenvolvimento de IPs.

“A autorregulação não é suficiente por si só. É importante que o governo e a sociedade também estejam engajados no combate à desinformação e às fake news, criando regulamentações e estratégias eficazes”

Antonielle Freitas

“O ChatGPT pode gerar roteiros rápidos, o que pode ser útil no desenvolvimento de novos IPs e teoricamente poderia ser treinado para produzir respostas que não infringem direitos autorais ou outras formas de propriedade intelectual (teoria de originalidade)”, destaca reforçando, no entanto que: “é difícil determinar a origem específica de cada resposta ou texto produzido pelo ChatGPT, o que pode trazer riscos relacionados a violações de direitos autorais ou de outros tipos de propriedade intelectual e ainda pode gerar respostas ou textos que contenham informações imprecisas ou até mesmo enganosas, o que pode resultar em informações equivocadas sendo disseminadas e potencialmente prejudicando terceiros.”