Tornar a análise de imagens mais eficiente, essa é uma das promessas da nova ferramenta de IA da Meta. Na semana passada, a empresa lançou um modelo chamado “Segment Anything Model” ou “SAM”, por meio do qual os usuários podem criar “recortes” ou segmentos de qualquer item em uma imagem clicando em um ponto ou desenhando uma caixa ao redor do objeto. A ferramenta pode ser usada para fins de pesquisa, para edição criativa ou até mesmo para dar sentido a objetos usando um headset VR, tornando mais rápido e eficiente cortar diferentes partes de uma imagem.

Leia mais: Com a entrada da Meta, corrida da IA fica ainda mais acirrada

A empresa de tecnologia lançou a ferramenta baseada em navegador para o público e também abriu o código de seu modelo de visão computacional, que afirma ser treinado no “maior conjunto de dados de segmentação” de 1,1 bilhão de máscaras de segmentação (“máscaras” são partes diferentes de uma imagem) e 11 milhões de imagens licenciadas de uma grande empresa fotográfica. A Meta não revelou de qual empresa licenciou as imagens.

As tecnologias de reconhecimento de objetos e visão computacional existem há anos e já estão integradas em vários dispositivos, como câmeras de vigilância e drones . As lojas da Amazon, por exemplo, usam o reconhecimento de objetos para detectar os itens que você coloca em sua cesta e os veículos autônomos o usam para perceber seus arredores. Startups como a Runway e empresas tradicionais como a Adobe comercializaram sua capacidade de usar IA para detectar e selecionar diferentes objetos em uma imagem para seus usuários criativos. À medida que os chatbots de IA generativos surgiram, o objetivo dos pesquisadores de IA da Meta era mesclar o avanço nos modelos fundamentais de IA com o domínio adormecido das tecnologias de visão computacional.

“Eu não diria que esta é uma nova área da tecnologia. A segmentação de objetos já existe, mas, fundamentalmente, acho que sua abordagem de usar modelos fundamentais é nova e o tamanho do conjunto de dados em que estão treinando pode ser novo”, diz Paul Powers, CEO e fundador da Physna, um mecanismo de busca de objetos 3D. Mas o que a Meta espera é que, ao liberar essas ferramentas de forma mais ampla, encoraje os usuários a construir em cima de seu modelo generalizado para casos de uso mais específicos em campos como biologia e agricultura.

Leia mais: A IA pode resolver os problemas de receita do Facebook?

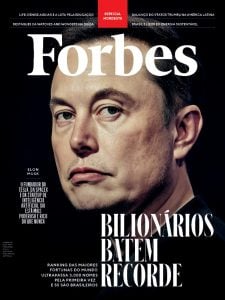

O anúncio ocorre simultaneamente, pois a Meta planeja usar IA generativa para anúncios no Instagram e no Facebook. Não querendo perder o “hype” em torno da IA. No final de fevereiro, o CEO Mark Zuckerberg anunciou que estava criando uma nova equipe de produto focada exclusivamente na criação de ferramentas generativas de IA, como avatares, filtros do Instagram e recursos baseados em bate-papo no WhatsApp e no Instagram. Zuckerberg, supostamente, tem passado a maior parte do tempo com a nova equipe de IA.

A ferramenta SAM é construída para aqueles que não têm infraestrutura de IA ou capacidade de dados para criar seus próprios modelos para “segmentar” ou identificar diferentes componentes de uma imagem, dizem os pesquisadores da Meta AI Alexander Kirillov e Nikhila Ravi. “Isso está acontecendo em tempo real no navegador e torna esse modelo muito mais acessível para muito mais pessoas”, diz Ravi.

Mas há limitações de um modelo de visão computacional treinado em um banco de dados de imagens bidimensionais, diz Powers. Por exemplo, para que a ferramenta detecte e selecione um controle remoto de cabeça para baixo, ela precisaria ser treinada em diferentes orientações do mesmo objeto. Modelos treinados em imagens 2D não ajudarão a detectar imagens parcialmente cobertas ou parcialmente expostas, diz ele. Isso significa que ele não identificaria com precisão objetos não padronizados por meio de um fone de ouvido AR/VR ou não detectaria objetos parcialmente cobertos em espaços públicos se usados por um fabricante de veículos autônomos.

Para a empresa, que mudou de Facebook para Meta no final de 2021 e firmou seu compromisso com o Metaverso, o uso mais óbvio para essa ferramenta de detecção de objetos é em seus espaços de realidade virtual, como seu jogo VR online Horizon Worlds. Kirillov e Ravi dizem que sua ferramenta de detecção de objetos pode ser usada para detecção de objetos “baseada no olhar” por meio de realidade virtual e fones de ouvido de realidade aumentada.

O modelo pode detectar objetos desconhecidos e trabalhar em vários domínios com imagens subaquáticas, microscópicas, aéreas e agrícolas. Kirillov diz que se inspirou para criar um modelo generalizado de segmentação de imagens enquanto conversava com pesquisadores de doutorado. “Eu estava fazendo uma apresentação sobre segmentação para alguns cientistas naturais em Berkeley e as pessoas disseram ‘Ok, claro, tudo isso é legal, mas preciso contar e identificar árvores nas fotos que coletei para minha pesquisa sobre incêndios na Califórnia ‘, e então este modelo pode fazer isso por eles”, disse Kirillov à Forbes.