“A inteligência artificial pode potencializar o humano quando ela leva em consideração um balanceamento dos benefícios e malefícios para o maior número de pessoas.”

O pesquisador Tarcízio Silva, referência em tecnologia e regulação, em especial inteligencia artificial, lançou, recentemente, o livro “Racismo Algorítmico: Inteligência Artificial e Discriminação nas Redes Digitais”. Na obra, ele reflete sobre os erros gerados por plataformas de IA e o impacto deles em questões como racismo e vieses.

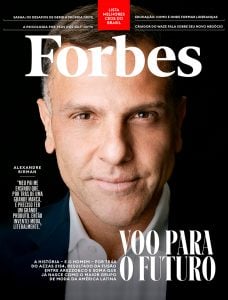

Para a Forbes Brasil, o autor destaca que não se pode minimizar os erros atuais da IA como simples “alucinações”, quando na verdade “tratam-se de informações que podem ser vistas como verdadeiras e ganharem escala de forma muito rápida”.

-

Siga a Forbes no WhatsApp e receba as principais notícias sobre negócios, carreira, tecnologia e estilo de vida

“Acredito que o termo ‘alucinação’ é inadequado pois parece humanizar os softwares, uma vez que alucinação seria uma desconexão entre interpretação da realidade e estímulos que não existem no mundo real. Quando um sistema afirma algo absurdamente errado, a fragilidade do sistema fica mais explícita, de fato.”, destaca.

Forbes Brasil – Recentemente, ao usar o Gemini do Google, e pedir uma linha do tempo sobre a vida de Elon Musk, ele afirmou que Musk se tornou presidente dos EUA em janeiro deste ano. Por que essas alucinações são nocivas e preocupantes?

Tarcízio Silva – Tais tipos de erros são muito comuns na chamada “inteligência artificial generativa”, que a rigor produz conteúdo aparentemente credível, mas se trata apenas de uma concatenação semi-aleatória de mídia anteriormente extraída de uma miríade de fontes. Nesse sentido, acredito que o termo “alucinação” é inadequado pois parece humanizar os softwares, uma vez que alucinação seria uma desconexão entre interpretação da realidade e estímulos que não existem no mundo real. Quando um sistema afirma algo absurdamente factualmente errado, a fragilidade do sistema fica mais explícita de fato. Mas o grande perigo é a capacidade de modulação em informações e conceitos disputados, mais sutis. Esses erros são preocupantes, pois tais tipos de tecnologias estão sendo vendidas por organizações como Microsoft, Meta e IBM como se fossem capazes de gerar informação relevante, substituir trabalho humano ou mesmo oferecer predições ou recomendações relevantes para diferentes áreas da vida. Por exemplo, se um sistema do tipo é disseminado como capaz de avaliar e representar a história de uma região, direcionamentos ideológicos e políticos podem ser fortalecidos e tomados como verdade.

FB – Em outras entrevistas, você já afirmou que as regulações atuais não são suficientes, existe alguma forma de regular que seja eficiente?

Tarcízio – Sim, hoje o que temos é basicamente uma autorregulação das grandes empresas de tecnologia, que estão tentando evadir até dos instrumentos legais que já temos, como o Código de Defesa do Consumidor. As propostas de regulação desenvolvidas por legisladores e experts avançaram em alguns pontos, mas são combatidas pelo lobby do setor privado. Por exemplo, a proposta de lei 2338/2023 avança em pontos essenciais, como a definição de uma gradação de riscos, com a inclusão de obrigações de transparência para implementações de alto risco e estabelecimento de obrigações de reparação por danos causados. Entretanto, novas propostas como a sugestão realizada pela atual Comissão Temporária de Inteligência Artificial no Senador fragilizam a defesa de direitos, como de fato permitindo o desenvolvimento e uso de tecnologias notadamente nocivas como reconhecimento facial no espaço público ou uso de armas autônomas.

FB – Existe um discurso atual das empresas que estão na frente da corrida da IA ( OpenAI, Nvidia) de que a IA potencializa o ser humano. Quais os cuidados que precisamos ter em relação a essas afirmações?

Tarcízio – A inteligência artificial pode potencializar o humano quando ela leva em consideração um balanceamento dos benefícios e malefícios para o maior número de pessoas. Sistemas algorítmicos com grande capacidade de processamento e escala são muito custosos financeiramente e ambientalmente. Um modelo de corrida por inovação voltada ao lucro e liderada pelo setor privado não vai potencializar o ser humano. Pelo contrário, vai aprofundar

desigualdades de diferentes ordens. Mecanismos de governança globais são necessários, que permitam os diferentes setores – priorizando sociedade civil – direcionem os caminhos do desenvolvimento tecnológico de modo que os recursos sejam compartilhados para priorizar implementações de impacto, como segurança alimentar.

FB – O que leva uma (ou várias) IAs a repetirem padrões racistas e como podemos combatê-los?

Tarcízio – Há fontes multidimensionais de reprodução das opressões e discriminações, que vão muito além das bases não-diversas de treinamento. Sim, o atual uso de grandes bases de dados, sem curadoria e sem diversidade, para treinamento de sistemas de inteligência artificial é uma das grandes questões. Mas a normalização de problemas discriminatórios por causa dessas práticas nos diz mais sobre as práticas corporativas do que a fragilidade das bases de dados. Grandes atores corporativos optaram por lançar tecnologias nocivas e falhas apesar do conhecimento dos problemas. A resposta está nos mecanismos de supervisão e governança externos aos desenvolvedores, que

estabeleçam obrigações ligadas a análise de impacto e justificação dos sistemas. Somente poderemos ter tecnologias digitais baseadas em IA não-discriminatórias quando as implementações de alto risco forem supervisionadas pela sociedade civil, através de organizações experts em defesa de direitos humanos e direito das minorias.