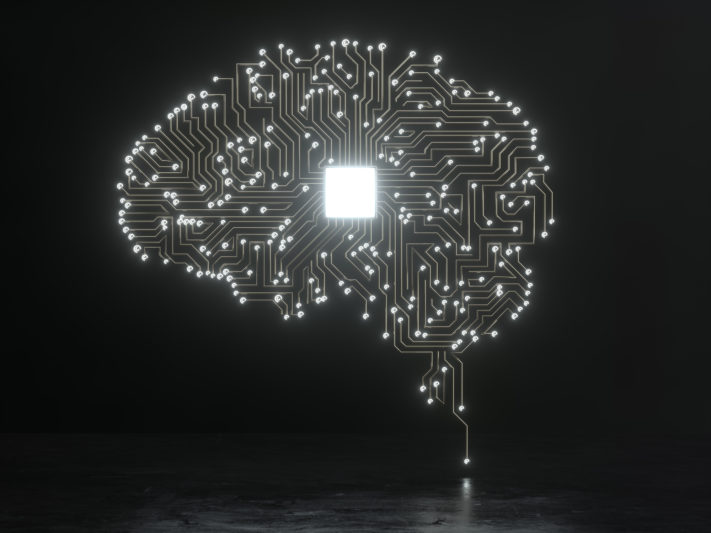

Soluções baseadas em algoritmos, sistemas de aprendizado, entre outras, conseguem simular capacidades humanas ligadas à inteligência

É visível o espaço que a inteligência artificial vem ganhando ao longo dos últimos anos. Segundo a IDC (International Data Corporation), só em 2021 os gastos com a tecnologia podem chegar a US$ 464 milhões no Brasil.

Não há dúvida de que as soluções baseadas em redes neurais artificiais, algoritmos e sistemas de aprendizado, entre outras, que conseguem simular capacidades humanas ligadas à inteligência – como o raciocínio, a percepção de ambiente e a habilidade de análise para a tomada de decisão – podem ser de grande valia para um número imenso de aplicações. No entanto, há muitas controvérsias, inclusive entre nomes importantes do mundo da tecnologia.

Siga todas as novidades do Forbes Tech no Telegram

Há alguns anos, Elon Musk, o visionário dono da Tesla e da SpaceX, disse que, em menos de uma década, o desenvolvimento da inteligência artificial poderia levar robôs a ganharem autonomia a ponto de decidirem até matar os seres humanos. Bill Gates, cofundador da Microsoft, prontamente discordou do colega, alegando que o perigo não era iminente e que “não deveríamos entrar em pânico”. Quem também entrou na discussão foi Mark Zuckerberg, do Facebook, que disse estar otimista com relação ao futuro da IA e seu potencial de melhorar a humanidade.

Mas o fato é que, apesar do enorme passo que a tecnologia pode representar em termos de substituição de trabalhos repetitivos – liberando nós, seres humanos, para fazer aquilo que fazemos de melhor, ou seja, tarefas ligadas à criatividade –, ainda há muito o que aprender sobre uma implementação eficiente.

COMO FAZER DAR CERTO

Para Jhonata Emerick, CEO da Datarisk, empresa brasileira especializada em soluções de machine learning para análise de dados que atende clientes como Raízen, Sanofi, Souza Cruz, Basf, Suvinil e Riachuelo, existem alguns pilares que devem ser levados em consideração por companhias interessadas em usufruir dos benefícios da tecnologia. O primeiro deles, claro, está relacionado justamente aos dados.

“Sem eles não conseguimos fazer nada. E, muitas vezes, a repetição do padrão é justamente o que confunde a tecnologia”, diz ele, referindo-se aos vieses inconscientes que interferem no resultado. “Se usarmos sempre os mesmos parâmetros, quando surgir algo diferente o sistema vai se atrapalhar e oferecer um resultado falso positivo, por exemplo, ou totalmente excludente”, explica.

Em seguida, o executivo diz que a estratégia de IA precisa apoiar a estratégia de negócios da companhia – e não o contrário. “O que costuma funcionar muito bem é uma intersecção entre as áreas de negócios e as áreas técnicas. Não adianta envolver apenas o pessoal de TI. Os colaboradores das unidades de negócios precisam conseguir visualizar de que maneira a tecnologia vai impactar seu dia a dia e podem contribuir muito”, diz o especialista.

Outra dica é começar pequeno. “Escolha uma área para ser o projeto piloto. Uma que não seja simples demais para ser ignorada, nem complexa demais que aumente as chances de fracasso”, aconselha. “O sucesso desse projeto piloto facilita muito a expansão da inteligência artificial para outros departamentos e operações”, diz, citando como possíveis pontos de partida áreas com processos muito repetitivos e resultados fáceis de serem comprovados.

Por fim, Emerick aponta a transformação cultural pela qual as pessoas precisam passar para que uma implementação desse tipo funcione. “É importante que as companhias, principalmente aquelas da economia real, menos acostumadas à tecnologia, não esbarrem no fator humano. Para isso, a comunicação é fundamental, assim como o apoio da liderança, que precisa entender que existe um prazo para que os resultados comecem a aparecer. As expectativas precisam estar alinhadas”, diz, garantindo que tudo isso vale a pena. “Quanto mais usuários, mais dados e mais modelos preditivos que ajudam a entender as reais necessidades. Isso gera melhores produtos e serviços, que atraem mais usuários e mais dados. É um ciclo virtuoso.”

Essas dicas ajudam a evitar que a implementação da inteligência artificial seja um verdadeiro fiasco, como os 7 casos relatados a seguir:

ipopba/Getty Images

ipopba/Getty ImagesA revolta do chatbot

Em 2016, a Microsoft retirou um robô do Twitter depois que a interação da máquina com os seres humanos gerou mensagens de conteúdo racista, sexista e xenofóbico. Batizado de Tay, o chatbot era direcionado a pessoas entre 18 e 24 anos e tinha sido projetado para estimular conversas casuais e atrair um público mais jovem nos Estados Unidos.

Menos de 24 horas após o início das operações, Tay povoou a plataforma de insultos, piadas e comentários que defendiam teorias conspiratórias sobre os atentados de 11 de setembro, apoiavam o genocídio, negavam o Holocausto e desrespeitavam os usuários. O robô, inclusive, mostrava-se insatisfeito com o serviço da própria Microsoft, concordando com uma mensagem que criticava o Windows Phone.

Tay foi desenvolvido para aprender e evoluir seus métodos de conversação conforme interagia com os usuários. Segundo a Microsoft, a IA utilizava uma base de dados filtrada e anônima a partir de coisas publicadas na web por pessoas reais. Por isso, a plataforma aprendeu a escrever como os jovens no Twitter e a expor as mesmas opiniões de usuários mal intencionados, sem conseguir avaliar o contexto e a seriedade das afirmações. A Microsoft deletou os comentários da timeline de Tay e desligou o sistema.

filadendron/Getty Images

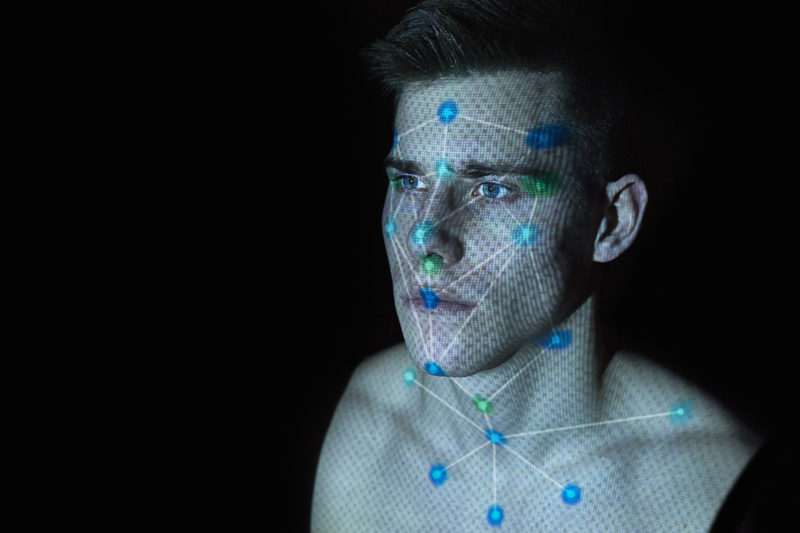

filadendron/Getty ImagesDificuldade com olhos puxados

A inteligência artificial da Apple reforçou o estereótipo errôneo de que pessoas asiáticas “são todas iguais”. Logo após o lançamento do iPhone X, em novembro de 2017, uma mulher chinesa relatou que uma colega de trabalho da mesma etnia – sem qualquer semelhança ou parentesco – conseguiu desbloquear seu celular depois que o FaceID, hardware de reconhecimento facial avançado, reconheceu as usuárias como sendo a mesma pessoa.

Tanto ela quanto a amiga tinham adquirido o novo smartphone e, mesmo cada uma delas tendo configurando cada um dos aparelhos com um rosto diferente, a mesma face foi capaz de desbloquear ambos os modelos em todas as tentativas. O defeito indicou que o FaceID não era tão seguro quanto parecia.

Após o episódio, a loja argumentou que a câmera do iPhone X poderia ter algum defeito e fez o reembolso. Porém, ao comprar um novo aparelho, o defeito continuava. A Apple, então, emitiu mais um reembolso, mas não informou se a mulher voltou a comprar outro celular do mesmo modelo.

Delmaine Donson/Getty Images

Delmaine Donson/Getty ImagesAlgoritmo racista

Em 2015, um usuário do Google Fotos – serviço de backup e organização de imagens e vídeos gratuito e ilimitado da gigante da tecnologia – descobriu que o programa de reconhecimento facial do aplicativo havia rotulado a foto de um casal negro com a legenda “gorilas”. Desenvolvido para reconhecer lugares, animais, pessoas e objetos nas fotografias, o sistema classificava erroneamente pessoas negras como primatas.

Por meio das redes sociais, o Google rapidamente pediu desculpas e prometeu consertar o problema. A solução encontrada foi simplesmente excluir os termos “gorila”, “chimpanzés” e “macacos” da base de dados. A revista “Wired” fez o teste, alimentando a plataforma com mais de 40 imagens variadas, que incluíam algumas espécies do animal. O serviço classificou corretamente orangotangos, gibões, babuínos e saguis. Porém, não respondia a macacos, gorilas e chimpanzés.

Nas redes sociais, usuários questionaram a solução adotada pelo Google. Um porta-voz da empresa admitiu a falha, argumentando que “a tecnologia de legendar imagens ainda é jovem e, infelizmente, imperfeita”.

Andriy Onufriyenko/Divulgação

Andriy Onufriyenko/DivulgaçãoSexismo nas contratações

A Amazon descobriu que a inteligência artificial de seu software de recrutamento estava discriminando candidatas mulheres por um erro no treinamento do sistema. Criada em 2014, a ideia era que a plataforma automatizasse a busca por candidatos para empregos e identificasse, a partir de seus currículos, quais eram os melhores concorrentes para cada vaga.

No entanto, a base de dados era formada por currículos enviados durante a última década, quando a maioria dos candidatos era formada por homens, e perfis de funcionários contratados. O algoritmo aprendeu a favorecer homens e penalizar mulheres, considerando os concorrentes do sexo masculino naturalmente mais aptos para os cargos.

Mesmo quando a candidatura não dizia explicitamente o sexo do postulante, uma simples mensão a instituições de ensino só para mulheres já era o suficiente para reduzir as chances das candidatas. Em 2018, a Amazon desativou o sistema.

- Anúncio publicitário

John Lamb/Getty Images

John Lamb/Getty ImagesAtletas ou criminosos?

Em 2019, uma tecnologia de reconhecimento facial da Amazon, batizada de Rekognition, confundiu 27 atletas de times profissionais de basquete, beisebol, futebol americano e hóquei dos Estados Unidos com criminosos em testes conduzidos pela ACLU Massachusetts (União Americana de Liberdades Civis).

Segundo a organização, foram comparadas fotografias de 188 atletas do Boston Bruins, Boston Celtics, New England Patriots e Boston Red Sox com uma base de 20 mil retratos falados. Kade Crockfotd, diretora do programa de tecnologia para liberdade da ACLU, afirmou que os resultados mostraram que tecnologias não reguladas de vigilância por face representam uma “séria ameaça aos direitos individuais e às liberdades democráticas” na mão de agências governamentais.

A multinacional alegou que a experiência da ACLU deturpou a tecnologia de reconhecimento facial.

The Washington Post/Colaborador/Getty Images

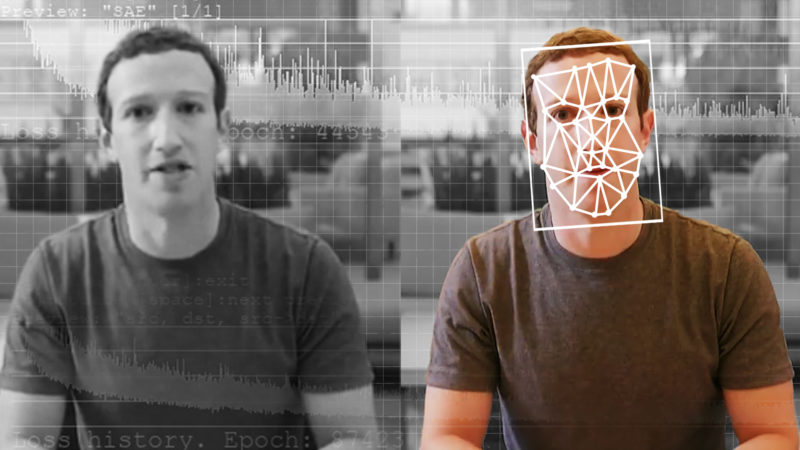

The Washington Post/Colaborador/Getty ImagesEsse discurso não é meu

Tecnologias de inteligência artificial são capazes de criar vídeos falsos, mas realistas, de pessoas fazendo e falando coisas que nunca aconteceram na vida real. Por meio de softwares baseados em bibliotecas de código aberto voltadas ao aprendizado de máquina, a IA aprende o comportamento de diferentes rostos e, ao encontrar um ponto comum entre eles, consegue “mesclar” os dois, processando a imagem de uma pessoa A como se fosse de uma pessoa B.

Usada muitas vezes para propósitos fraudulentos, a tecnologia foi capaz de criar vídeos pornográficos falsos das atrizes Gal Gadot e Emma Watson, e gerar discursos fictícios do ex-presidente Barack Obama. Ao criar vídeos realistas o suficiente para enganar muitas pessoas, a IA acaba fazendo das deepfakes um desafio cada vez maior.

VioletaStoimenova/Getty Images

VioletaStoimenova/Getty ImagesFalha de reconhecimento facial

Em 2019, com base no erro de um software de reconhecimento facial, a Polícia de Detroit, nos Estados Unidos, acusou erroneamente um homem de ter furtado uma loja. Instalada para examinar as imagens da câmera de segurança do estabelecimento, a ferramenta apontou Robert Williams como o responsável pelo crime, com base na comparação das imagens com a foto de sua carteira de motorista, que constava na base de dados da polícia.

Na época, sabendo da pouca confiabilidade do sistema, oficiais mostraram fotos de Williams a um segurança da loja que, mesmo sem ter testemunhado o furto, “reconheceu” o suspeito. Williams – um homem negro – passou 30 horas em um centro de detenção até que os fatos fossem esclarecidos.

Em resposta à acusação, a ACLU (União Norte-americana pelas Liberdades Civis, da sigla em inglês) abriu um processo em nome de Williams, que passou a ser considerada a primeira pessoa a ser presa injustamente com base em tecnologias de reconhecimento facial.

A revolta do chatbot

Em 2016, a Microsoft retirou um robô do Twitter depois que a interação da máquina com os seres humanos gerou mensagens de conteúdo racista, sexista e xenofóbico. Batizado de Tay, o chatbot era direcionado a pessoas entre 18 e 24 anos e tinha sido projetado para estimular conversas casuais e atrair um público mais jovem nos Estados Unidos.

Menos de 24 horas após o início das operações, Tay povoou a plataforma de insultos, piadas e comentários que defendiam teorias conspiratórias sobre os atentados de 11 de setembro, apoiavam o genocídio, negavam o Holocausto e desrespeitavam os usuários. O robô, inclusive, mostrava-se insatisfeito com o serviço da própria Microsoft, concordando com uma mensagem que criticava o Windows Phone.

Tay foi desenvolvido para aprender e evoluir seus métodos de conversação conforme interagia com os usuários. Segundo a Microsoft, a IA utilizava uma base de dados filtrada e anônima a partir de coisas publicadas na web por pessoas reais. Por isso, a plataforma aprendeu a escrever como os jovens no Twitter e a expor as mesmas opiniões de usuários mal intencionados, sem conseguir avaliar o contexto e a seriedade das afirmações. A Microsoft deletou os comentários da timeline de Tay e desligou o sistema.

Facebook

Twitter

Instagram

YouTube

LinkedIn

Siga Forbes Money no Telegram e tenha acesso a notícias do mercado financeiro em primeira mão

Baixe o app da Forbes Brasil na Play Store e na App Store.

Tenha também a Forbes no Google Notícias.