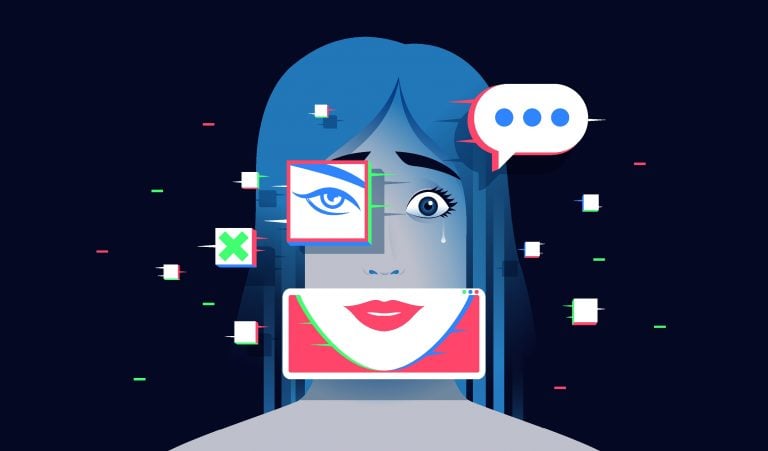

Conteúdos gerados por IA, desde imagens ilegais de pornografia infantil até deepfakes de políticos, estão infestando a internet. O CEO da startup Hive, Kevin Guo, acredita que os sistemas de moderação de conteúdo de sua empresa são um “antivírus moderno” contra publicações fraudulentas.

Plataformas como Reddit e Bluesky já utilizam os sistemas da Hive, que empregam modelos de aprendizado de máquina para identificar conteúdos nocivos. Agora, graças a uma nova parceria com a Internet Watch Foundation (IWF), ONG britânica de proteção infantil, a startup está equipada para identificar e remover material pornográfico com a imagem de crianças e adolescentes dos sites de seus clientes.

Para isso, a Hive integrará os conjuntos de dados da organização, que incluem uma lista regularmente atualizada de cerca de 8.000 sites que hospedam imagens confirmadas de CSAM — sigla em inglês para Material de Abuso Sexual Infantil —, tanto reais quanto geradas por IA, em seus modelos.

As informações disponibilizadas pela ONG também incluem frases e palavras-chave criptografadas utilizadas por infratores para ocultar CSAM e burlar a moderação. Como parte do acordo, os clientes da Hive poderão acessar os “hashes” da IWF — impressões digitais de milhões de imagens e vídeos de abuso conhecidos.

A parceria expande a colaboração da Hive com a Thorn, ONG americana que desenvolve tecnologia de detecção de CSAM, para ampliar seu alcance e eliminar mais conteúdos criminosos das plataformas de seus clientes.

A nova colaboração tem como objetivo conter a enxurrada de imagens de crianças geradas por IA, das quais infratores para fins ilícitos. Em 2023, a IWF sinalizou mais de 275.000 páginas da web contendo CSAM para autoridades, um número recorde para a organização.

“CSAM era, anteriormente, razoavelmente difícil de obter. Esse conteúdo não era tão comum”, disse Guo à Forbes. “Esses mecanismos de geração por IA, tanto de imagens quanto de vídeos, abrem portas completamente diferentes.”

Fundada em 2014 como uma rede social, a Hive mudou de direção em 2017 para vender suas ferramentas internas de moderação de conteúdo. Atualmente, além de detectar publicações inadequadas, os modelos de IA da empresa podem identificar logotipos, reconhecer milhares de celebridades, cópias de filmes e programas de TV. Com sede em São Francisco, a empresa levantou US$ 120 milhões em capital de risco de investidores como General Catalyst e foi avaliada em US$ 2 bilhões em 2021.

A ascensão da IA se traduziu em crescimento para a Hive, cuja receita multiplicou-se 30 vezes desde 2020. A empresa processa 10 bilhões de conteúdos por mês de seus 400 clientes, incluindo plataformas de redes sociais, streaming e o Pentágono.

Em dezembro de 2024, a Hive garantiu um contrato de US$ 2,4 milhões com o Departamento de Defesa dos Estados Unidos para garantir que os conteúdos recebidos pelas equipes sejam reais e confiáveis.

Também há um interesse crescente de empresas de verificação de documentos e seguradoras, que relataram um aumento de falsas reivindicações, “as pessoas tiram uma foto do carro e a IA gera um arranhão”, contou Guo.

O CEO não está preocupado com a abordagem do presidente Donald Trump em relação à regulamentação da IA. Embora ele tenha revogado a ordem executiva da administração Biden que delineava medidas para lidar com deepfakes, a segurança infantil online é uma questão “bastante bipartidária”, afirma Guo. “Não acreditamos que essa parte vá desaparecer.”