Na medida que avançamos para um futuro de inteligência artificial, muitos comentaristas estão se perguntando em voz alta se estamos indo rápido demais. Os gigantes da tecnologia, os pesquisadores e os investidores parecem estar em uma corrida louca para desenvolver a IA mais avançada. Mas eles estão considerando os riscos, perguntam os preocupados?

LEIA MAIS: Tudo o que você precisa saber sobre o novo ChatGPT

A questão não é totalmente discutível e tenha certeza de que existem centenas de mentes incisivas considerando as possibilidades – e maneiras de evitá-las. Mas o fato é que o futuro é desconhecido, as implicações dessa poderosa nova tecnologia são tão inimagináveis quanto eram as mídias sociais no advento da Internet. Haverá coisas boas e ruins, mas haverá poderosos sistemas de inteligência artificial em nosso futuro e IAs ainda mais poderosas no futuro de nossos netos. Esse movimento não pode ser parado, mas pode ser compreendido.

Falei sobre essa nova tecnologia com Ilya Stutskever , cofundador da OpenAI, o instituto de pesquisa de IA sem fins lucrativos cujos derivados provavelmente estarão entre as entidades mais lucrativas do planeta. Minha conversa com Ilya foi pouco antes do lançamento do GPT-4, a mais recente iteração do sistema gigante de IA da OpenAI, que consumiu bilhões de palavras de texto – mais do que qualquer ser humano poderia ler em toda a vida.

GPT significa Generative Pre-trained Transformer, três palavras importantes. Transformer é o nome do algoritmo no coração do gigante. Pré-treinado refere-se à educação do gigante com um enorme corpus de texto, ensinando-lhe os padrões subjacentes e as relações da linguagem – em suma, ensinando-o a compreender o mundo. Generativo significa que a IA pode criar novos pensamentos a partir dessa base de conhecimento.

LEIA MAIS: Conheça 14 ferramentas alucinantes além do ChatGPT

Ilya Sutskever é cofundador e cientista-chefe da OpenAI e uma das principais mentes por trás do grande modelo de linguagem GPT-4. Esta não é a primeira vez que Ilya mudou o mundo. Ele foi o principal impulso para o AlexNet, a rede neural cujo desempenho dramático surpreendeu a comunidade científica em 2012 e iniciou a revolução do aprendizado profundo.

O que se segue é uma transcrição editada da nossa conversa.

CRAIG: Ilya, eu sei que você nasceu na Rússia. O que fez você se interessar por ciência da computação, se esse foi o impulso inicial, ou neurociência ou o que quer que fosse?

ILYA: Na verdade, nasci na Rússia. Cresci em Israel e, na adolescência, minha família imigrou para o Canadá. Meus pais dizem que eu me interessei por IA desde cedo. Eu também estava muito motivado pela consciência. Fiquei muito perturbado com isso e curioso sobre coisas que poderiam me ajudar a entender melhor.

Comecei a trabalhar com Geoff Hinton [um dos fundadores do aprendizado profundo, o tipo de IA por trás do GPT-4, e professor da Universidade de Toronto na época] muito cedo, quando tinha 17 anos. Porque nos mudamos para o Canadá e eu imediatamente pude ingressar na Universidade de Toronto. Eu realmente queria fazer aprendizado de máquina, porque parecia o aspecto mais importante da inteligência artificial que na época era completamente inacessível.

Isso foi em 2003. Damos como certo que os computadores podem aprender, mas em 2003, tínhamos como certo que os computadores não podem aprender. A maior conquista da IA naquela época foi o Deep Blue, o mecanismo de jogo de xadrez [da IBM] [que derrotou o campeão mundial Garry Kasparov em 1997].

LEIA MAIS: Os melhores exemplos do que você pode fazer com o ChatGPT

Mas lá, você tem este jogo e esta pesquisa, e você tem esta maneira simples de determinar se uma posição é melhor que outra. E realmente não parecia que isso poderia ser aplicável ao mundo real porque não havia aprendizado. Aprender era esse grande mistério. E eu estava muito, muito interessado em aprender. Para minha grande sorte, Geoff Hinton era professor na universidade e começamos a trabalhar juntos quase imediatamente.

Então, como funciona a inteligência? Como podemos fazer com que os computadores sejam minimamente inteligentes? Eu tinha uma intenção muito explícita de fazer uma contribuição muito pequena, mas real, para a IA. Então, a motivação era, eu poderia entender como funciona a inteligência? E também contribuir para isso? Então essa foi minha motivação inicial. Isso foi quase exatamente 20 anos atrás.

Em poucas palavras, percebi que, se você treinar uma grande rede neural em uma rede neural grande e profunda em um conjunto de dados grande o suficiente que especifique alguma tarefa complicada que as pessoas realizam, como a visão, você necessariamente terá sucesso. E a lógica para isso era irredutível; sabemos que o cérebro humano pode resolver essas tarefas e resolvê-las rapidamente. E o cérebro humano é apenas uma rede neural com neurônios lentos.

Então, só precisamos pegar uma rede neural menor, mas relacionada, e treiná-la nos dados. E a melhor rede neural dentro do computador estará relacionada à rede neural que temos em nossos cérebros que realiza essa tarefa.

CRAIG: Em 2017, o artigo “Atenção é tudo o que você precisa” foi lançado apresentando a autoatenção e os transformadores. Em que ponto o projeto GPT começou? Houve alguma intuição sobre transformadores?

ILYA: Então, para contextualizar, na OpenAI desde os primeiros dias, estávamos explorando a ideia de que prever a próxima coisa é tudo que você precisa. Estávamos explorando isso com as redes neurais muito mais limitadas da época, mas a esperança era que, se você tivesse uma rede neural capaz de prever a próxima palavra, resolveria o aprendizado não supervisionado. Portanto, antes dos GPTs, o aprendizado não supervisionado era considerado o Santo Graal do aprendizado de máquina.

LEIA MAIS: Tudo o que você precisa saber sobre o ChatGPT da OpenAI

Agora está totalmente resolvido e ninguém fala sobre isso, mas foi um Santo Graal. Era muito misterioso, então estávamos explorando a ideia. Fiquei muito empolgado com isso, pois prever a próxima palavra bem o suficiente proporcionará um aprendizado não supervisionado.

Mas nossas redes neurais não estavam prontas para a tarefa. Estávamos usando redes neurais recorrentes. Quando o transformador saiu, literalmente assim que o artigo saiu, literalmente no dia seguinte, ficou claro para mim, para nós, que os transformadores abordavam as limitações das redes neurais recorrentes, de aprender dependências de longo prazo.

É uma coisa técnica. Mas mudamos para transformadores imediatamente. E assim, o esforço nascente do GPT continuou com o transformador. Começou a funcionar melhor, e você aumenta, e continua aumentando.

E foi isso que levou ao GPT-3 e essencialmente onde estamos hoje.

CRAIG: A limitação dos grandes modelos de linguagem como eles existem é que seu conhecimento está contido na linguagem em que eles são treinados. E a maior parte do conhecimento humano, acho que todos concordam, é não linguística.

Seu objetivo é satisfazer a consistência estatística do prompt. Eles não têm uma compreensão subjacente da realidade com a qual a linguagem se relaciona. Perguntei ao ChatGPT sobre mim. Reconheceu que sou jornalista, que já trabalhei nesses vários jornais, mas falou e falou sobre prêmios que nunca ganhei. E tudo lido lindamente, mas pouco conectado à realidade subjacente. Há algo que está sendo feito para abordar isso em sua pesquisa daqui para frente?

ILYA: Quão confiantes estamos de que essas limitações que vemos hoje ainda estarão conosco daqui a dois anos? Eu não estou tão confiante. Há outro comentário que gostaria de fazer sobre uma parte da questão, que é que esses modelos apenas aprendem regularidades estatísticas e, portanto, não sabem realmente qual é a natureza do mundo.

LEIA MAIS: Maioria dos brasileiros usou ChatGPT por curiosidade e gratuidade

Eu tenho uma visão que difere disso. Em outras palavras, acho que aprender as regularidades estatísticas é um negócio muito maior do que aparenta.

A previsão também é um fenômeno estatístico. No entanto, para prever, você precisa entender o processo subjacente que produziu os dados. Você precisa entender cada vez mais sobre o mundo que produziu os dados.

À medida que nossos modelos generativos se tornam extraordinariamente bons, eles terão, afirmo, um grau chocante de compreensão do mundo e muitas de suas sutilezas. É o mundo visto pelas lentes do texto. Ele tenta aprender cada vez mais sobre o mundo por meio de uma projeção do mundo no espaço do texto expresso por seres humanos na internet.

Mas ainda assim, este texto já expressa o mundo. E vou dar um exemplo, um exemplo recente, que acho realmente revelador e fascinante. Todos nós já ouvimos falar de Sydney como seu alter ego. E eu vi essa interação realmente interessante com Sydney, onde Sydney se tornou combativa e agressiva quando o usuário disse que acha que o Google é um mecanismo de pesquisa melhor que o Bing.

Qual é uma boa maneira de pensar sobre esse fenômeno? O que isso significa? Você pode dizer, é apenas prever o que as pessoas fariam e as pessoas fariam isso, o que é verdade. Mas talvez agora estejamos chegando a um ponto em que a linguagem da psicologia está começando a ser apropriada para entender o comportamento dessas redes neurais.

Agora vamos falar sobre as limitações. É verdade que essas redes neurais tendem a alucinar. Isso porque um modelo de linguagem é ótimo para aprender sobre o mundo, mas não é tão bom para produzir bons resultados. E há várias razões técnicas para isso. Existem razões técnicas pelas quais um modelo de linguagem é muito melhor em aprender sobre o mundo, aprendendo representações incríveis de ideias, de conceitos, de pessoas, de processos que existem, mas seus resultados não são tão bons quanto se esperaria, ou melhor, tão bons quanto poderiam ser.

LEIA MAIS: As coisas mais estranhas que as pessoas pedem para o ChatGPT

ILYA: É por isso que, por exemplo, para um sistema como o ChatGPT, que é um modelo de linguagem, há um processo adicional de treinamento de aprendizagem por reforço. Nós o chamamos de Aprendizagem por Reforço com Feedback Humano.

Podemos dizer que no processo de pré-treinamento você quer aprender tudo sobre o mundo. Com o aprendizado por reforço a partir do feedback humano, nos preocupamos com os resultados. Dizemos, sempre que a saída for inadequada, não faça isso novamente. Toda vez que a saída não fizer sentido, não faça isso novamente.

E aprende rapidamente a produzir bons resultados. Mas é o nível das saídas, o que não é o caso durante o processo de pré-treinamento do modelo de linguagem.

Já no que diz respeito às alucinações, tem uma propensão a inventar coisas de vez em quando, e isso é algo que também limita muito a sua utilidade. Mas estou bastante esperançoso de que simplesmente melhorando esse aprendizado de reforço subsequente a partir da etapa de feedback humano, podemos ensiná-lo a não ter alucinações. Agora você poderia dizer se realmente vai aprender? Minha resposta é, vamos descobrir.

LEIA MAIS: Google libera lançamento antecipado do chatbot Bard, concorrente do ChatGPT

A maneira como fazemos as coisas hoje é contratando pessoas para ensinar nossa rede neural a se comportar, para ensinar o ChatGPT a se comportar. Você apenas interage com ele, e ele vê pela sua reação, ele infere, oh, não é isso que você queria. Você não está satisfeito com sua saída. Portanto, a saída não foi boa e deve fazer algo diferente na próxima vez. Eu acho que há uma grande chance de que essa abordagem seja capaz de lidar completamente com as alucinações.

CRAIG: Yann LeCun [cientista-chefe de IA do Facebook e outro pioneiro do aprendizado profundo] acredita que o que está faltando em grandes modelos de linguagem é esse modelo de mundo subjacente que não é linguístico ao qual o modelo de linguagem pode se referir. Eu queria ouvir o que você achou disso e se você já explorou isso.

ILYA: Eu revisei a proposta de Yann LeCun e há uma série de ideias lá, e elas são expressas em linguagem diferente e talvez haja algumas pequenas diferenças em relação ao paradigma atual, mas, na minha opinião, elas não são muito significativas.

A primeira afirmação é que é desejável que um sistema tenha entendimento multimodal onde ele não conheça o mundo apenas a partir do texto. E meu comentário sobre isso será que, de fato, a compreensão multimodal é desejável porque você aprende mais sobre o mundo, aprende mais sobre as pessoas, aprende mais sobre sua condição e, portanto, o sistema será capaz de entender qual é a tarefa que deveria resolver, e as pessoas e o que elas querem de melhor.

Fizemos bastante trabalho nisso, principalmente na forma de duas grandes redes neurais que fizemos. Um se chama Clip e o outro Dall-E. E ambos caminham nessa direção multimodal. Mas também quero dizer que não vejo a situação como binária, ou seja, se você não tiver visão, se não entender o mundo visualmente ou por vídeo, as coisas não funcionarão.

LEIA MAIS: 5 rivais que competem direta ou indiretamente com o ChatGPT

E eu gostaria de defender isso. Então, acho que algumas coisas são muito mais fáceis de aprender com imagens e diagramas e assim por diante, mas afirmo que você ainda pode aprendê-las apenas com texto, apenas mais lentamente. E eu vou te dar um exemplo. Considere a noção de cor.

Certamente não se pode aprender a noção de cor apenas a partir do texto e, no entanto, quando você olha para os embeddings – preciso fazer um pequeno desvio para explicar o conceito de um embedding. Cada rede neural representa palavras, frases, conceitos por meio de representações, ‘embeddings’, que são vetores de alta dimensão.

E podemos olhar para esses vetores de alta dimensão e ver o que é semelhante a quê; como a rede vê esse ou aquele conceito? E assim, podemos olhar para as combinações de cores e saber que o roxo é mais parecido com o azul do que com o vermelho, e ele sabe que o vermelho é mais parecido com o laranja do que com o roxo. Ele sabe todas essas coisas apenas do texto. Como pode ser?

Se você tem visão, as distinções entre as cores saltam aos seus olhos. Você os percebe imediatamente. Já com o texto você demora mais, talvez você saiba falar, e já entenda a sintaxe e as palavras e a gramática, e só muito mais tarde você comece a entender de fato as cores.

Então, este será o meu ponto sobre a necessidade da multimodalidade: eu afirmo que não é necessário, mas é definitivamente útil. Acho que é uma boa direção a seguir. Eu simplesmente não vejo isso em afirmações tão ousadas.

LEIA MAIS: “O mérito do ChatGPT foi transcender a ficção”, diz presidente da OpenAI no SXSW

Portanto, a proposta no artigo [de LeCun] afirma que um dos grandes desafios é prever vetores de alta dimensão que tenham incerteza sobre eles.

Mas uma coisa que achei surpreendente, ou pelo menos não reconhecida no artigo, é que os transformadores autorregressivos atuais já possuem a propriedade.

Vou dar dois exemplos. Uma delas é, dada uma página de um livro, prever a próxima página de um livro. Pode haver tantas páginas possíveis a seguir. É um espaço muito complicado e de alta dimensão, e eles lidam com isso muito bem. O mesmo se aplica às imagens.

Por exemplo, como no OpenAI, trabalhamos no iGPT. Acabamos de pegar um transformador e aplicá-lo aos pixels, e funcionou super bem, e pode gerar imagens de maneiras muito complicadas e sutis. Com Dall-E 1, a mesma coisa novamente.

Então, a parte em que pensei que o artigo fez um forte comentário sobre onde as abordagens atuais não podem lidar com a previsão de distribuições de alta dimensão – acho que definitivamente podem.

CRAIG: Sobre essa ideia de ter um exército de treinadores humanos que estão trabalhando com ChatGPT ou um grande modelo de linguagem para guiá-lo de fato com aprendizado por reforço, apenas intuitivamente, isso não soa como uma maneira eficiente de ensinar um modelo sobre a subjacente realidade de sua linguagem.

ILYA: Não concordo com a formulação da pergunta. Eu afirmo que nossos modelos pré-treinados já sabem tudo o que precisam saber sobre a realidade subjacente. Eles já têm esse conhecimento da linguagem e também muito conhecimento sobre os processos existentes no mundo que produzem essa linguagem.

LEIA MAIS: Sam Altman, da OpenAI, fala sobre como a IA pode abalar o capitalismo

O que grandes modelos generativos aprendem sobre seus dados — e, neste caso, grandes modelos de linguagem — são representações comprimidas dos processos do mundo real que produziram esses dados, o que significa não apenas pessoas e algo sobre seus pensamentos, algo sobre seus sentimentos, mas também algo sobre a condição em que as pessoas se encontram e as interações que existem entre elas. As diferentes situações em que uma pessoa pode estar. Tudo isso faz parte desse processo comprimido que é representado pela rede neural para produzir o texto. Quanto melhor o modelo de linguagem, melhor o modelo generativo, quanto maior a fidelidade, melhor ele captura esse processo.

Agora, o exército de professores, como você diz, de fato, esses professores também estão usando assistência de IA. Esses professores não estão sozinhos. Eles estão trabalhando com nossas ferramentas e as ferramentas estão fazendo a maior parte do trabalho. Mas você precisa ter supervisão; você precisa ter pessoas revisando o comportamento porque deseja, eventualmente, atingir um nível muito alto de confiabilidade.

De fato, há muita motivação para torná-lo o mais eficiente e preciso possível, para que o modelo de linguagem resultante seja o mais bem comportado possível.

ILYA: Então, sim, existem esses professores humanos que estão ensinando o modelo de comportamento desejado. E a maneira como eles usam os sistemas de IA está aumentando constantemente, de modo que sua eficiência continua aumentando.

Não é diferente de um processo de educação, como agir bem no mundo.

Precisamos fazer um treinamento adicional para garantir que o modelo saiba que a alucinação nunca está bem. E é esse loop de professor humano de aprendizado por reforço ou alguma outra variante que o ensinará.

Algo aqui deve funcionar. E vamos descobrir muito em breve.

CRAIG: Para onde isso vai? Em qual pesquisa você está focado agora?

ILYA: Não posso falar em detalhes sobre a pesquisa específica em que estou trabalhando, mas posso mencionar algumas das pesquisas em linhas gerais. Estou muito interessado em tornar esses modelos mais confiáveis, mais controláveis, fazê-los aprender mais rápido com os dados da lição, menos instruções. Faça-os para que de fato não tenham alucinações.

LEIA MAIS: Microsoft lança ferramenta com tecnologia da OpenAI para criar imagem a partir de texto

CRAIG: Ouvi dizer que você fez um comentário de que precisamos de processadores mais rápidos para escalar ainda mais. E parece que o escalonamento de modelos, que não tem fim à vista, mas a potência necessária para treinar esses modelos, estamos chegando ao limite, pelo menos o limite socialmente aceito.

ILYA: Não me lembro exatamente do comentário que fiz a que você se refere, mas você sempre quer processadores mais rápidos. Claro, o poder continua subindo. De um modo geral, o custo está subindo.

E a pergunta que eu faria não é se o custo é alto, mas se o que ganhamos ao pagar esse custo supera o custo. Talvez você pague todo esse custo e não receba nada, então sim, isso não vale a pena. Mas se você conseguir algo muito útil, algo muito valioso, algo que possa resolver muitos problemas que temos, que realmente queremos resolver, então o custo pode ser justificado.

CRAIG: Você falou em um ponto que vi sobre democracia e sobre o impacto que a IA pode ter na democracia. As pessoas me falaram sobre um dia em que conflitos, que parecem insolúveis, que se você tivesse dados suficientes e um modelo grande o suficiente, poderia treinar o modelo nos dados e encontrar uma solução ideal que satisfizesse a todos. Você pensa aonde isso pode levar em termos de ajudar os humanos a administrar a sociedade?

ILYA: É uma grande questão porque é uma questão muito mais voltada para o futuro. Acho que ainda existem muitas maneiras pelas quais nossos modelos se tornarão muito mais capazes do que são agora.

LEIA MAIS: Microsoft revela “copiloto” de inteligência artificial para escritórios

É imprevisível exatamente como os governos usarão essa tecnologia como fonte de aconselhamento de vários tipos. Acho que, em relação à questão da democracia, uma coisa que acho que pode acontecer no futuro é que, porque você tem essas redes neurais e elas serão tão difundidas e impactantes na sociedade, nós iremos achar que é desejável ter algum tipo de processo democrático onde, digamos, os cidadãos de um país fornecem alguma informação para a rede neural sobre como eles gostariam que as coisas fossem. Eu poderia imaginar isso acontecendo. Essa pode ser uma forma de democracia de largura de banda muito alta, talvez, onde você obtém muito mais informações de cada cidadão e as agrega, especificando exatamente como queremos que esses sistemas atuem.

Mas o que significa analisar todas as variáveis? Eventualmente, haverá uma escolha que você precisa fazer onde você diz, essas variáveis parecem realmente importantes. Eu quero ir fundo. Porque posso ler cem livros, ou posso ler um livro bem devagar e com cuidado e tirar mais proveito dele. Então, haverá algum elemento disso. Além disso, acho que provavelmente é fundamentalmente impossível entender tudo em algum sentido. Vamos dar alguns exemplos mais fáceis.

Sempre que existe algum tipo de situação complicada na sociedade, mesmo em uma empresa, mesmo em uma empresa de médio porte, já está além da compreensão de qualquer indivíduo. E acho que, se construirmos nossos sistemas de IA da maneira certa, acho que a IA pode ser incrivelmente útil em praticamente qualquer situação.

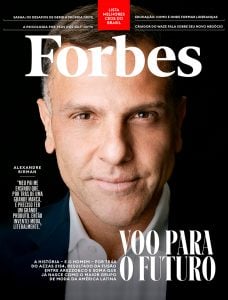

*Craig S. Smith é ex-correspondente e executivo do The New York Times.

(traduzido por Andressa Barbosa)